- 签证留学 |

- 笔译 |

- 口译

- 求职 |

- 日/韩语 |

- 德语

Bayesian分类器(Duda and Hart,1973)、决策表(Rivest,1987)、决策树(Quinlan,1986)、神经网络(Rumelhart et al.,1986)、逻辑学习系统(Mooney,1995)以及邻近方法(Cover and Hart,1967)等都适用于该模式。这里将只讨论朴素Bayes(naive Bayes)方法和决策表方法,因为它们是词义排歧中最常用的方法。

用于WSD的朴素Bayes分类器的方法基于下面的假设:为输入向量选择最佳涵义等同于为该指定向量选择最可能的涵义。换言之:

在这个公式中,S表示合乎该向量关联目标词的词义的涵义集,s表示在S中每个可能的涵义,V代表输入上下文的向量表示。与大部分的情形相同,很难直接获取这个方程的统计信息。因此,我们需要以下面常见的Bayes方式重写该公式:

显然,指定向量与涵义之间可获取的相关数据由于太过稀疏而无法使用。然而,在已标注训练集中包含大量的有关在指定涵义的上下文中单个特征值偶对的信息。因此,我们可以做出下面的独立假设(这是该方法名称的来源,我们也曾在词性标注、语音识别以及概率剖析中成功地使用过这个假设):我们朴素地(natively)假设特征之间彼此独立。利用这个假设则可以产生下面的对P(Vls)的近似:

换言之,在指定涵义的条件下,我们可以通过向量单个特征的条件概率的乘积来估算整个向量的条件概率。

已知上面的方程式,训练一个朴素Bayes分类器就等同于从已标注涵义的训练语料库中收集关于目标词的每个涵义与单个特征之间的相关统计信息。为了具体化这个概念,让我们回到例句(17.11)。这个例句所需的单个统计信息可能包括单词player出现在每个bass涵义的右边紧靠位置的概率,或者包括单词guitar出现在每个bass涵义的左边相隔一个单词的位置的概率。

回到方程式(17.13),项P(s)是每个涵义的先验概率,它恰好对应于每个涵义在标注涵义的语料库中所占的比例。最后,由于P(V)对所有可能的涵义都是相同的,因此不会影响最终涵义的排列顺序,可以忽略不计而得到下式:

显然,关于零计数和平滑的技术都可以用在此处。

在一次评测许多监督学习方法的大型实验中,Mooney(1996)指出朴素Bayes分类器和神经网络的性能最好,它们在为包含单词line的例句语料库指派line的6个涵义中的一个时都取得了约73%的正确率。

决策表分类器(decision list classifier)等同于大部分程序语言中的简单分支语句。在一个决策表分类器中,一连串的测试被应用于每个以向量为编码的输入。如果这个测试成功,则返回与该测试相关的涵义。如果这个测试失败,则进行序列中的下一个测试。继续这个过程直到列表的结尾,这时一个默认测试将简单地返回最常见的涵义。

图17.1给出了为从bass的音乐涵义中区分出鱼的涵义的任务而设计的部分决策表。第一个测试表示,如果单词fish在输入文本中的任何位置出现,则bass是正确的答案。如果没有出现,则依次进行每个后续的测试直到返回真值。与分支语句一样,在列表的结尾处包含一个返回真值的默认测试。

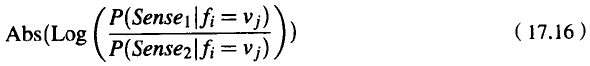

学习决策表分类器的过程是由基于训练数据特征的单个测试的生成和排序组成的。许多方法都可以用于生成这种列表。在Yarowsky(1994)所用的方法中,每个单独的特征值偶对组成一个测试。然后这些测试按照在整个训练集中各自的精度来排序,测试的精度基于它的对数似然值:

根据这个计算值,通过对列表中的测试进行简单排序就可以从这些测试中生成决策表。Yarowsky(1996)指出,这种技术在各种二元决策任务中都取得了超过95%的正确率。

应该指出,这里的训练方法与标准决策表学习算法有相当大的不同。这些方法的细节以及理论依据可以参阅Rivest(1987)或Russell and Norvig (1995)。