- 签证留学 |

- 笔译 |

- 口译

- 求职 |

- 日/韩语 |

- 德语

把语音输入通过信号处理变换并转换成一系列特征矢量,每个矢量代表语音输入的一个时间片,然后把这些特征矢量转变成概率。

特征矢量的概率的一种计算方法是,首先进行聚类(cluster),把它们聚类为能够计数的离散符号,然后计算它们在某个训练集中出现的次数。只要对次数进行计数,就可以计算出给定聚类的概率。这种方法一般称为矢量量化(vector quantization)。矢量量化在早期的语音识别算法中使用得非常普遍,但后来这种方法被一种更直接而且计算能力更强的方法所替代,即计算输入矢量实数值的(连续的)观察概率。这种方法要在一个连续的空间内计算概率强度函数(probability density function, 简称pdf)。

有两种普遍使用的连续方法。这两种方法中使用得最广泛的是高斯概率强度函数(Gaussian pdf)。在最简单的高斯概率强度函数中,每个状态有一个单独的高斯函数,把观察矢量Ot映射为概率。另一种方法是使用神经网络或多层感知器,这种方法也能够通过训练给概率指派一个实数值的特征矢量。带有高斯观察概率估计器的HMM可以通过简单地扩充向前-向后算法进行训练而得到。带有神经网络观察概率估计器的HMM可以通过一种完全不同的、称为错误反向传播(error back-propagation)的算法进行训练而得到。

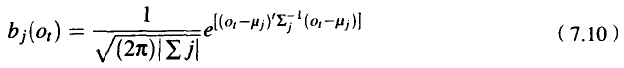

最简单地使用高斯概率强度函数时,我们假定观察特征矢量Ot的可能的值是按照正态分布的,这样就可以把观察概率函数bj(Ot)表示为带有平均矢量μj和协方差矩阵Σj的高斯曲线;下标数表示矢量转置。为了保持完整性,这里写下了整个等式,但我们并不想深究这个等式的数学细节:

在通常情况下,我们简单地假定,协方差矩阵Σj,是一个对角矩阵,也就是说,它包含倒谱特征1的简单方差,倒谱特征2的简单方差,等等,而不考虑倒谱特征1对倒谱特征2方差的影响。这意味着,在实际工作中,对于特征矢量的每个特征,我们只是简单地保持它的平均值和方差。

大多数语音识别系统的做法更复杂一些。对于每个状态,它们使用多重的高斯函数,这样,在计算观察矢量的每个特征的概率时,就要加上高斯曲线的一个变体。这种技术称为高斯混合法(Gaussian mixture)。另外,在一种称为参数约束(parameter tying)或约束混合法(tied mixture)的技术中,状态之间可以共享高斯函数(Huang and Jack,1989)。例如,在声学上相似的音子的某些特征就可以共享高斯函数。

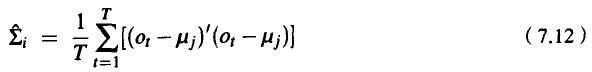

怎样计算在高斯估计中的平均值和方差呢?再次考虑只有一个状态i的非隐藏的马尔可夫模型会对我们有所帮助。特征平均矢量μ和方差矢量Σ可以通过平均的办法来估计:

但是,由于存在着多个隐藏的状态,我们不知道哪个观察矢量Ot,是由哪个状态产生的。可以修改向前-向后算法,把在时间t和状态i的HMM的概率分摊给每个可能的状态i,从而对每个可能的状态i指派一个观察矢量Ot。

模拟连续值特征的另一种方法是神经网络,又称多层感知器(MLP),或人工神经网络(Artificial Neural Network,简称ANN)。神经网络很复杂,用一两页篇幅不可能介绍清楚,但我们可以直观地说明,作为一种与高斯估计不同的方法,神经网络如何应用于概率估计。有兴趣的读者

可以阅读有关神经网络基础知识的教材(Anderson,1995;Hertz et al.,1991)以及一些与神经网络语音识别有关的专业文献(Bourlard and Morgan,1994)。

神经网络是用加权链(weighted link)连接起来的一些小的计算单元的集合。给神经网络一个输入值矢量,它就可以计算出一个输出值矢量。在计算过程中,神经网络的每个计算单元计算输入单元的某个非线性函数,并把结果值传给其输出单元。