- 签证留学 |

- 笔译 |

- 口译

- 求职 |

- 日/韩语 |

- 德语

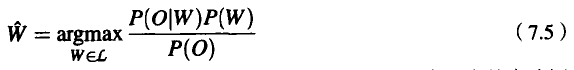

可以用式(7.4)来替换式(7.3)中的有关项,得到:

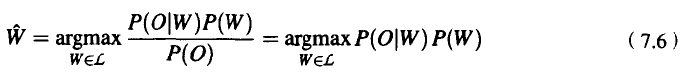

式(7.5)中右侧的大部分概率与概率P(WIO)相比更容易计算。例如,P(W)是单词串本身的先验概率,我们可以根据N元语法的语言模型进行估计。下面将会看到,P(OIW)也很容易估计出来。但是,声学观察序列的概率P(O)却很难估计。不过,幸运的是,我们可以忽略P(O)。为什么呢?因为我们现在要对所有可能的句子求最大值,我们将对语言中的每个句子计算 。但是每个句子的P(O)是不会改变的!因为对于每个潜在的句子,我们总是要检查同样的观察O,而观察都有同样的概率P(O)。因此,我们有:

。但是每个句子的P(O)是不会改变的!因为对于每个潜在的句子,我们总是要检查同样的观察O,而观察都有同样的概率P(O)。因此,我们有:

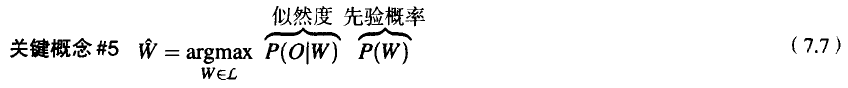

总的来说,对于给定的某个观察O,具有最大概率的句子W可以用每个句子的两个概率的乘积来计算,并且选乘积最大的句子为所求的句子。这两个术语的名称如下:P(W)是先验概率,称为语言模型(language model);P(OIW)是观察似然度,称为声学模型(acoustic model)。

首先,为了简化起见,我们假定输入序列是一个音子序列F,而不是一个声学观察序列。向前算法对于给定的音子序列的观察,能够产生出对于给定单词的这些音子的观察概率。我们将说明,这样的概率音子自动机实际上是隐马尔可夫模型(HMM)的一种特殊情况,并且也将说明如何扩充这个模型,使之对于给定的一个完整句子能够给出音子序列的概率。

然而,正如我们说过的,向前算法遇到的一个问题是:为了发现哪个单词是最可能的单词(即“解码问题”),需要对每个单词再次运行向前算法。对于句子来说,要这样做显然是行不通的,因为无法对英语中的每个可能的句子都分别运行向前算法。因此,这里介绍两种不同的算法,对于给定的句子,它们能同时计算出观察序列的似然度,并且给出最可能的句子。这两种算法是Viterbi算法和A*解码算法。

对于一个包含音子串的简化输入,当我们解决了似然度的计算和解码问题之后,将说明如何把同样的算法应用于真实的声学输入而不是事先定义好的音子。为此,我们将简短地介绍声学输入和特征抽出(feature extraction)。所谓特征抽出,就是从输人的声波中提取有意义的特征的过程。然后,我们将介绍从这些特征中计算音子概率的两个标准模型:高斯模型和神经网络模型(neural net model)。神经网络模型又称多层感知器模型(multi-layer perceptron model)。

最后,我们将介绍训练隐马尔可夫模型的标准算法和音子概率估计算法,向前-向后算法或Baum-Welch算法(Baum,1972),期望最大算法(Expectation-Maximization algorithm,或称EM算法)的一种特殊情况(Dempster et al.,1977)。

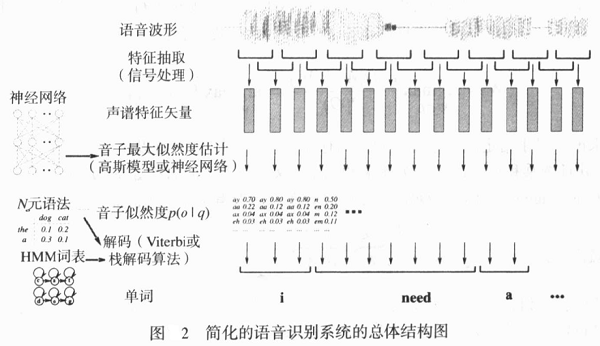

图2是语音识别系统的各个组成部分的大致轮廓。图中说明,一个语音识别系统可以分为三个阶段:信号处理阶段(signal stage)、音子阶段(phone stage)和解码阶段(decoding stage)。信号处理阶段又称为特征抽取阶段,在这个阶段,语音的声学波形切分为音片框架(通常是10ms,15ms或20ms),把音片框架转换成声谱特征,声谱特征要给出不同频度的信号的能量大小的信息。音子阶段又称为亚词阶段(subword stage),在这个阶段,我们使用诸如神经网络或高斯模型这样的统计技术,尝试识别如p或b这样的单个语音。对于神经网络,这个阶段的输出是对于每个音片的音子的概率矢量,例如,对于某个音片,[p]的概率是0.8,[b]的概率是0.1,[f]的概率是0.02,等等;对于高斯模型,概率与此稍有不同。最后,在解码阶段,我们利用单词发音词典和语言模型(概率语法),采用Viterbi算法或A*解码算法发现对于给定声学事件具有最大概率的单词序列。

责任编辑:admin